ALIA es el LLM público español. Hasta hace no mucho se sabía poco de él. Durante meses, solo hubo dos clústers de noticias:

- Uno, alrededor del 25 de febrero de 2024, coincidiendo con el anuncio de la cosa (véase, por ejemplo, esto o esto).

- Otro, alrededor de abril de 2024, cuando se anunció un acuerdo con IBM para el desarrollo de dicho modelo (veáse esto o esto). En esa época ya tenía nombre, ALIA, y se lo esperaba para después del verano (véase esto).

Después hubo una especie de apagón informativo —acabó el verano y yo no paraba de pulsar F5 en Google en vano— solo rasgado por una críptica nota de Alberto Palomo, aquel que fue ungido tiempo atrás como el CDO del Reino de España, que en una entrevista en El Confidencial a principios de diciembre decía de pasada que:

Competir con ChatGPT igual no es lo mejor. Es algo que se le criticó a Escrivá, que estaba invirtiendo en Alia, el ChatGPT en castellano, algo que en parte ya está resuelto. Hacer ChatGPT costó 650 millones de euros, Alia son 10 millones. Habrá que ver qué sale de ahí.

Y eso es más o menos todo con lo que hubo que contentarse durante cierto tiempo. Aunque lo es también (me refiero a cierto) que brujuleando oblicuamente podía uno encontrar pequeñas joyas informativas como esta charla de uno de los responsables de ALIA, Aitor González-Agirre (sic), en la Universidad de Jaén.

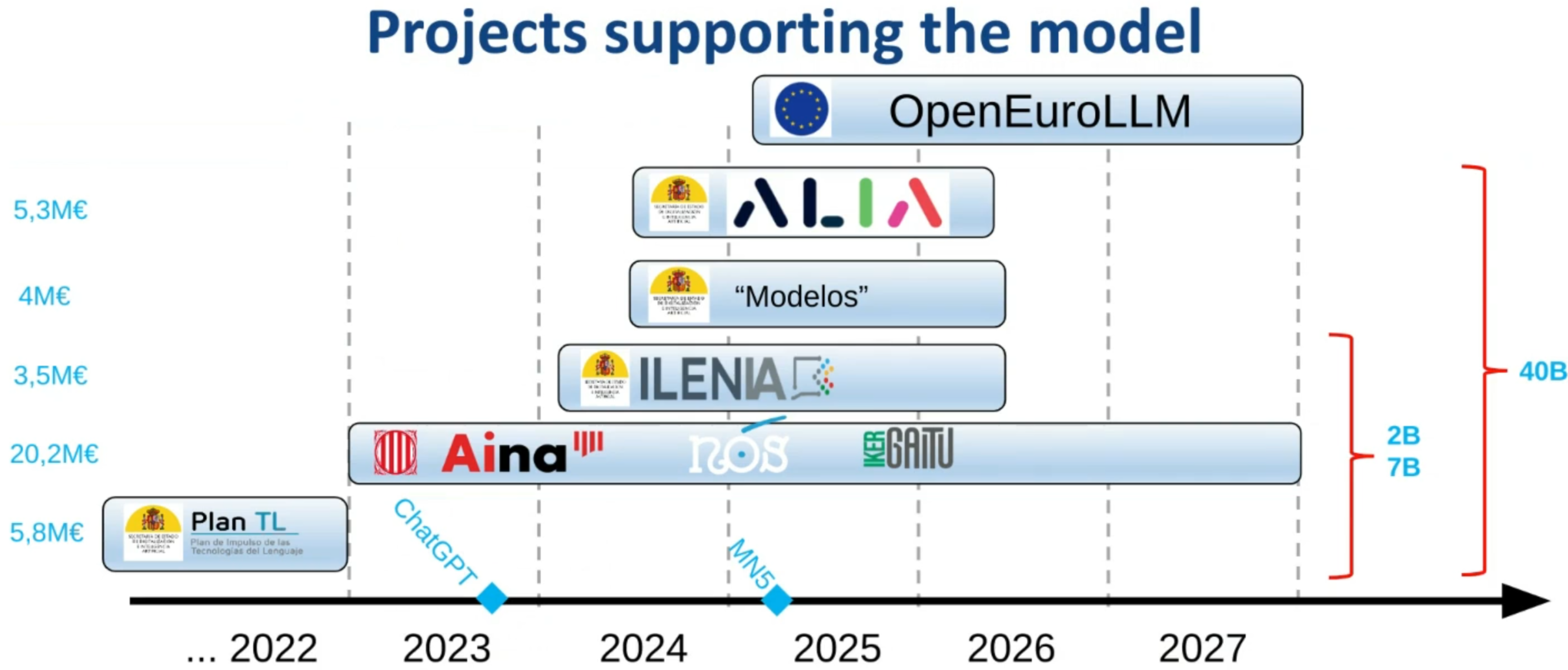

En la charla se discuten temas como los conjuntos de datos utilizados, cómo se ha hecho para sobremuestrear los múltiples y bienqueridos idiomas patrios, las características del ordenador (el MareNostrum 5) con el que se entrena, la existencia de varios modelos (Salamandra en dos versiones, 2B y 7B, y ALIA, más grande, de 40B), etc. De todas las diapositivas, rescato la tal vez más informativa,

que aclara muchos asuntos.

(Nota: eso del Plan TL de los cinco kilos creo que tiene que ver con estos repos de encefalograma plano que vaya uno a saber que recorrido extraacadémico pudieron llegar a tener.)

Sobre el MareNostrum 5 hay que hacer algunas puntualizaciones. Efectivamente, es uno de los ordenadores más grandes del mundo: en noviembre de 2024 era el onceno. Pero al final, apenas cuenta con $1120 \times 4$ GPUs H100, que no es gran cosa. Es ciertamente el doble de GPUs que el clúster en el que se ha entrenado DeepSeek-V3, pero que se queda muy corto con respecto a lo que se viene estilando por ahí. Aquellos que deseen averiguar por qué los grandes clústers de GPUs usados para entrenar LLMs no aparecen en la lista de los mayores ordenadores (a pesar de que les dan mil vueltas en términos de FLOPS), bien se lo pueden preguntar a su LLM favorito.

Finalmente, hace apenas unos días, se publicó la página oficial de ALIA, que enlaza además con la página de información técnica de los distintos modelos creados y que permite llegar hasta los repos donde reside el código de la cosa, como este. Ahora todo el mundo habla de la cosa y estará por ver a dónde llega.

Mi pequeña apuesta es que van a comenzar a publicarse capturas de pantalla de alucinaciones del modelo sosteniendo posturas discutibles —tengo algunas que me han pasado, pero como no puedo garantizar su autenticidad, me guardo de mostrarlas—, se armará un revuelo considerable y nos entretendremos todos bastante observando el espectáculo.

Panem (para los becados del proyecto) et circenses (para los demás).