Más sobre la relación entre la dispersión de las probabilidades y el AUC en modelos bien calibrados

Esta entrada está relacionada —aunque no es estrictamente una continuación— de la que escribí hace una semana sobre el mismo asunto.

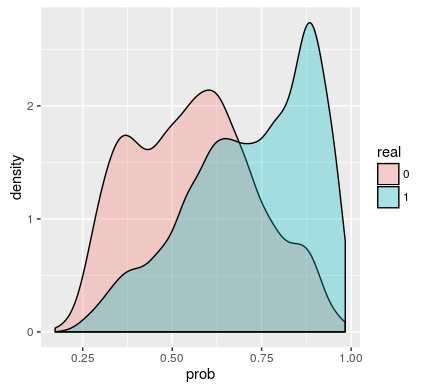

Se vuelve a partir de lo siguiente: un modelo de clasificación binaria bien calibrado. Eso significa que si el modelo predice $p$ para el sujeto $i$, entonces $Y_i \sim B(p)$.

Supongamos que tenemos una población dada, aplicamos el modelo y obtenemos una distribución $f(p)$ para las probabilidades predichas. Entonces, la distribución de: