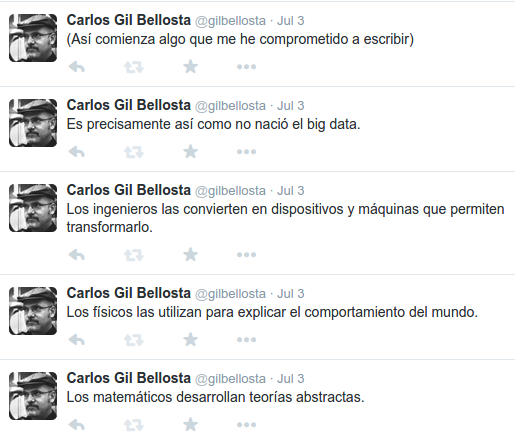

Antropocentrismo cansino

Es muy cansino. No hay debate sobre big data, inteligencia artificial o similar en el que no pase: de repente lo captura alguien (con pinta de no haber tirado una maldita línea de código en la vida) llevándoselo al tema con el que asustan a las porteras: ¡oh, oh, oh, la protección de datos!, ¡la nueva normativa europea! Que si Facebook sabe lo que hiciste, que si Google conoce tus amigos, que si…