I.

Es habitual tener dos modelos $m_1$ y $m_2$ y querer compararlos. Supongamos que son modelos de clasificación binaria —aunque nada de lo que sigue cambia realmente si son de clasificación categórica en un sentido más amplio—; vamos a suponer también que son modelos probabilísticos, en el sentido de que no producen directamente una predicción sino una probabilidad que puede luego convertirse en una predicción de acuerdo con cierta regla (p.e., predecir la categoría más probable).

¿Cómo se evalúan los modelos? Se toma un conjunto de datos, se los pone a predecir y se comparan los resultados usando scorings.

II.

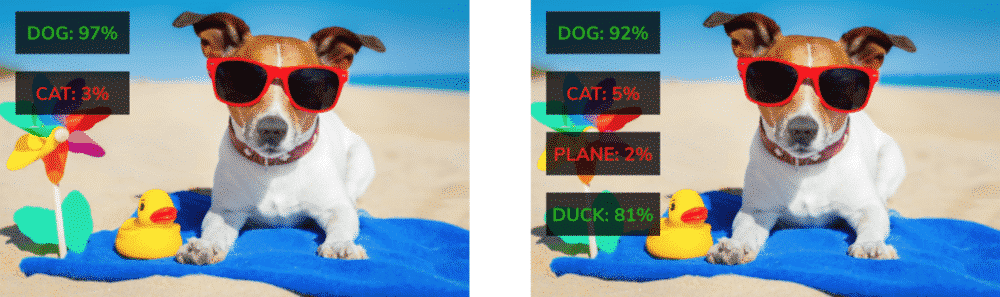

Existen muchos tipos de scorings, pero las taxonomías habituales distinguen dos categorías generales: los propios y los impropios. Los scorings impropios fomentan el comportamiento estratégico (i.e., que el modelo estime una probabilidad pero publique otra más conveniente, como aquí) y pueden hacer que un modelo inferior parezca superior (véase, por ejemplo, esto).

Uno de los scorings más populares es el accuracy, o proporción de aciertos. Desafortunadamente, no es un scoring propio.

III.

Los defensores del accuracy argumentan lo siguiente (p.e., aquí):

- Al final, lo importante es la predicción; si un modelo predice sistemáticamente mejor que otro, es mejor.

- El que dichas predicciones puedan estar basadas en probabilidades sesgadas es irrelevante si a uno le da igual la inferencia clásica (o la explicabilidad del modelo).

Y tienen cierta razón.

IV.

Sin embargo, es útil contar con la confianza de las predicciones: una predicción con una confianza baja podría ser analizada específicamente en un caso de uso real. Porque no es lo mismo que te digan tienes una fisura en la rótula que podría ser que tuvieses una fisura en la rótula; en el segundo caso, es probable que acaben realizando una radiografía adicional, por ejemplo.

Así que querríamos que nuestros modelos:

- Proporcionasen la confianza de sus predicciones.

- Asignasen una probabilidad alta a sus predicciones cuando acertasen.

- Errasen con una confianza relativamente baja.

V.

Un examen de respuesta múltiple (o binaria) no es otra cosa que un procedimiento como el indicado al principio para comparar modelos (o estudiantes). A estos se les pone delante un conjunto de datos nuevo y se les pide que realicen predicciones. Dichas predicciones se suelen evaluar usando un scoring impropio: el accuracy.

¿No tendría más sentido usar un scoring propio?

Notas finales:

- El hecho de que tendría más sentido usar un scoring propio nos lo revela, además, el hecho de que en muchos exámenes de respuesta múltiple se penaliza más el error que el dejar la respuesta en blanco. ¡Es una manera rudimentaria de evitar los problemas que plantea que el accuracy sea impropio!

- Seguro que no soy el primero al que se le ha ocurrido la idea y que de adentrarme en la literatura sobre la cosa encontraría muchas referencias a resultados empíricos acerca de por qué mi propuesta no funcionaría. Pero no, no voy a convertirme en abogado de una quimera; me interesa más la discusión sobre los scorings propios e impropios que sus presuntas aplicaciones a este o aquel problema particular.

- Quizás a alguien le interese probar algunos de los ejercicios que aparecen en A List of Probability Calibration Exercises. Son enlaces a exámenes de cultura más o menos general donde uno puede indicar la confianza con que elige una u otra opción. No son propiamente ejercicios de calibración (el título es, pues, engañoso) sino de evaluación propiamente dicha. La calibración es otra cosa: una predicción que predijese siempre la respuesta A con una confianza del 50% estaría bien calibrada pero no valdría para un carajo (en la mayoría de los casos de uso que se me ocurren ahora).