Más capítulos del libro de estadística (y otras cosas y proyectos para 2021)

Por un lado, he publicado tres capítulos más de mi libro de estadística desde el último anuncio. Son el (brevísimo) de introducción a la estadística, y los dedicados a la estadística descriptiva y la estimación puntual.

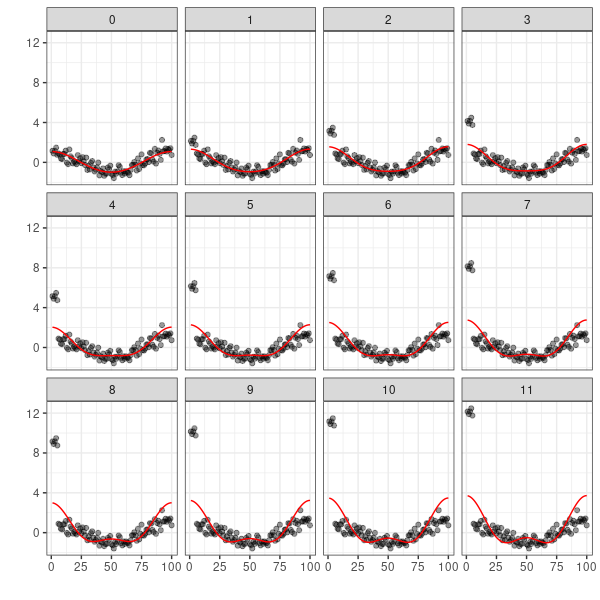

Hay algunas cosas en ellos que no se encuentran habitualmente en otros manuales. Por ejemplo, en el hecho de plantear determinados modelos como meras herramientas de visualización de datos (o de apoyo a ellas) en el de la estadística descriptiva. También se han recogido en ese capítulo las discusiones relevantes sobre lo que es un missing o un outlier y cómo tratarlos en general.