El "precio medio de la electricidad" no es el precio medio de la electricidad

Por ahí se ven cosas como esta:

Avisa del valor máximo, mínimo y medio de la electricidad en la mayor parte de España. Pero lo que llama precio medio no es el precio medio. Llama precio medio al resultado de

select avg(pvpc)

from pvpc_electricidad

where

date(dia_hora) = '2024-03-12'

;y no de

select sum(pvpc * kwh) / sum(kwh)

from pvpc_electricidad

where

date(dia_hora) = '2024-03-12'

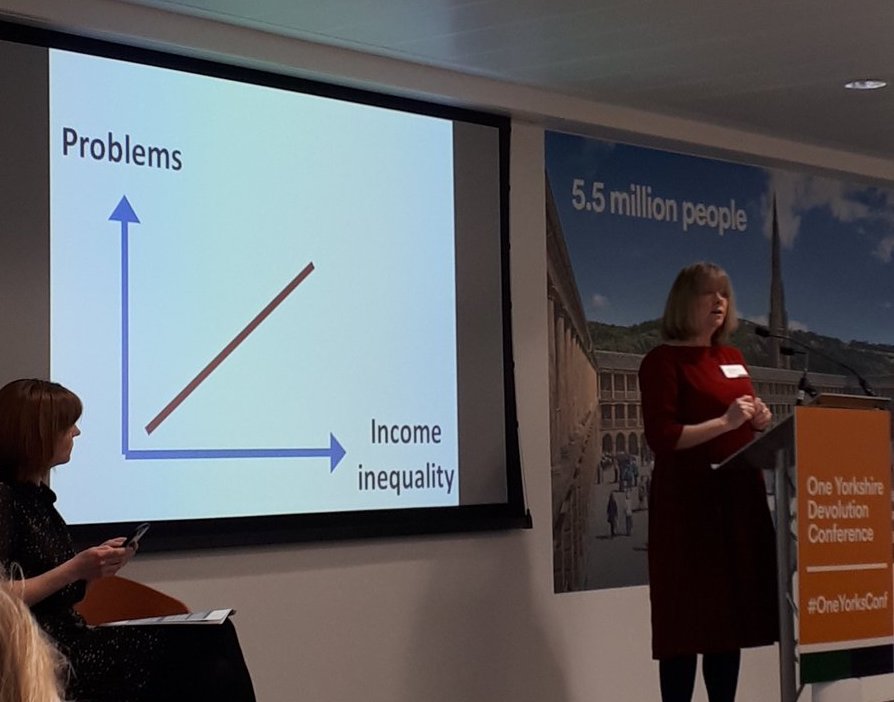

;que sería lo suyo. Nótese cómo, en particular, el precio está positivamente correlacionado con el consumo —si es que el mercado eléctrico funciona como se espera de él— por lo que la primera expresión será siempre menor que la segunda. Es un indicador sesgado.